HDFS集群搭建

更新时间:2018年12月19日15时25分 来源:传智播客 浏览次数:

| 一、linux服务器ssh免密码登录 假设有三台服务器的ip分别是10.9.1.101、10.9.1.102、10.9.1.103

分别修改三台服务器的hosts的文件(vi /etc/hosts),

在hosts文件中增加

10.9.1.101 node101 10.9.1.102 node102

10.9.1.103 node103

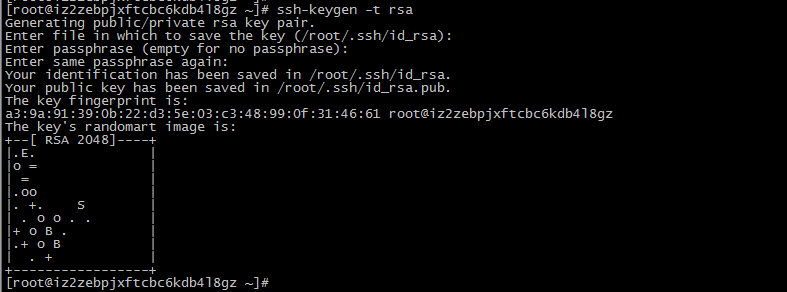

2.在101机器上生成公钥和私钥

ssh-keygen -t rsa

3.将101上生成的id_rsa.pub文件拷贝到102的相同目录下 由于我在101上使用的hadoop用户,生成的文件目录在/home/hadoop目录下,所在102上同样使用hadoop用户操作

将101上的/home/hadoop/id_rsa.put文件拷贝到102的/home/hadoop目录下

4.在102上创建.ssh目录

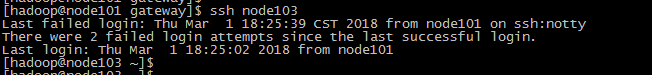

ssh node103

6.多台机器部署

1、下载hadoop安装包

上述过程只配置了101到103免密码登录,如果还需要配置102到103免密码登录时,只需要在102机器上重复上述步骤2,然后将生成的id_rsa.pub文件中的内容追加到103的authorized_keys文件末尾即可。

二、hadoop集群搭建(hdfs)

wget http://mirror.bit.edu.cn/apache/hadoop/common/hadoop-3.0.0/hadoop-3.0.0-src.tar.gz

2、解压安装包

tar zxvf hadoop-3.0.0-src.tar.gz

3、配置hadoop的环境变量

vi /etc/profile(三台机器)

增加以下配置

1、下载hadoop安装包

wget http://mirror.bit.edu.cn/apache/hadoop/common/hadoop-3.0.0/hadoop-3.0.0-src.tar.gz

2、解压安装包

tar zxvf hadoop-3.0.0-src.tar.gz -C /home/hadoop/

3、配置hadoop的环境变量

vi /etc/profile(三台机器)

增加以下配置

[AppleScript] 纯文本查看 复制代码

source /etc/profile

4、修改配置文件 vi /etc/hosts(三台机器)

增加以下配置

[AppleScript] 纯文本查看 复制代码

vi /home/hadoop/hadoop-3.0.0/etc/hadoop/core-site.xml(三台机器)

[AppleScript] 纯文本查看 复制代码

vi /home/hadoop/hadoop-3.0.0/etc/hadoop/hdfs-site.xml(三台机器)

[AppleScript] 纯文本查看 复制代码

vi /home/hadoop/hadoop-3.0.0/etc/hadoop/hadoop-env.sh (三台机器)

设置java_home(54行左右)

export JAVA_HOME=/usr/java/jdk1.8.0_11

vi /home/hadoop/hadoop-3.0.0/etc/hadoop/worker(namenode节点机器)

[AppleScript] 纯文本查看 复制代码

备注:node101、node102、node103分别是三台服务器设置的名称

5、初始化namenode节点

/home/hadoop/hadoop-3.0.0/bin/hadoop namenode -format

6、启动hdfs

/home/hadoop/hadoop-3.0.0/sbin/start-dfs.sh

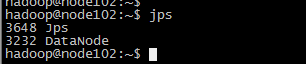

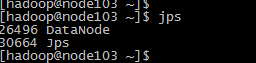

7、检查hdfs集群启动情况

jps

在namenode节点的机器上能看到namenode和datanode两个进程,在datanode节点的机器上只能看到datanode进程,我安装的namenode在node101机器上,datanode是101~103

备注:当启动出错的时候可以去hadoop安装的根目录下的logs目录下查看错误日志

(因为我只需要使用hdfs文件存储,所以暂时只配置这么多,如果还需要map-reduce等其他的功能还要配置其他的东西,这个只能以后有机会再整理了)

|

作者:传智播客大数据培训学院

AI智能应用开发(Java)

AI智能应用开发(Java) 鸿蒙应用开发

鸿蒙应用开发 HTML&JS+前端

HTML&JS+前端 Python+大数据开发

Python+大数据开发 人工智能开发

人工智能开发 跨境电商

跨境电商 电商视觉设计

电商视觉设计 软件测试

软件测试 新媒体+短视频

新媒体+短视频 集成电路应用开发

集成电路应用开发 C/C++

C/C++ 狂野架构师

狂野架构师 IP短视频

IP短视频